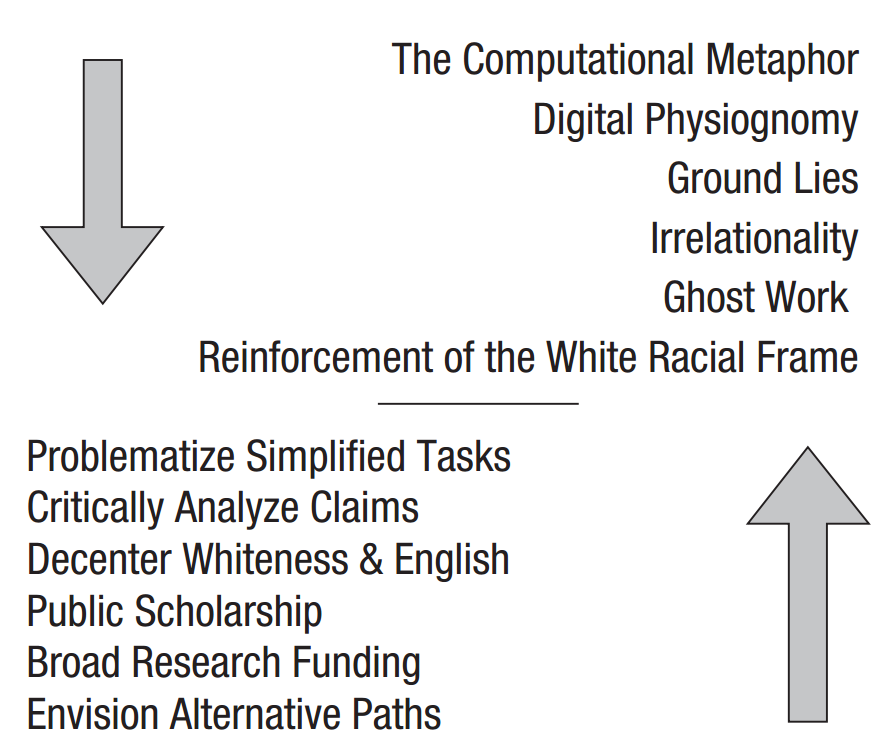

如今对AI的应用有着非人化(dehumanization)的倾向,认知科学家们正在抵制这种趋势。图 1 上面部分是AI实践过程中非人化的方法,下面部分是认知科学家抵制的方法。

1 研究路径(问题提出)

这个问题的提出源自于作者和合作者的两篇论文。

Bender & Koller (2020) 认为大语言模型只是生成了一段流畅的语句,但它没有沟通意图,也无法理解语句的含义。同时作者认为大语言模型无法学会训练材料没有给出的内容。

该论文是ACL 2020最佳主题论文

Bender, E. M., & Koller, A. (2020). Climbing towards NLU: On meaning, form, and understanding in the age of data. In D. Jurafsky, J. Chai, N. Schluter, & J. Tetreault (Eds.), Proceedings of the 58th annual meeting of the association for computational linguistics (pp. 5185–5198). Association for Computational Linguistics. https://doi.org/10.18653/v1/2020.acl-main.463

Bender et al. (2021) 通过总结关于大语言模型风险和缓解策略的论文,讨论了大语言模型在发展过程中出现的问题。

论文主要内容包含以下几点:

从环境种族主义(environmental racism)的视角探讨了环境成本(environmental cost)

经济成本及其对研究参与机会的影响

训练数据集中充斥着霸权(hegemonic)观点,且缺乏说明和责任追究

文本生成机器会复现训练集中的压迫系统(systems of oppression),并误导人类

这篇论文创造了随机鹦鹉(stochastic parrots)这个术语来形象的形容大语言模型文本生成的情况:依赖关于语言组合的概率信息,随意地拼接出语言片段,但完全不考虑意义。

压迫系统指种族主义、性别偏见等。

Bender, E. M., Gebru, T., McMillan-Major, A., & Shmitchell, S. (2021). On the dangers of stochastic parrots🦜: Can language models be too big? (pp. 610–623). Association for Computing Machinery. https://doi.org/10.1145/3442188.3445922

2 非人化的工作定义(Working Definition)

一种不将他人视为完全的人(fully human)的认知状态

表现出不将他人视为完全的人的认知状态或断言的行为

经历某种表达出对自己人性的不承认,和/或否定了人的基本体验或人权,或以上情况的组合的行为

整体来看可归纳为:认知状态、行为和被非人化的体验三部分。

原文如下:

the cognitive state of failing to perceive another human as fully human

an act that expresses that cognitive state or otherwise entails the assertion that another human is not fully human

the experience of being subjected to an act that expresses a lack of perception of one’s humanity and/or denies human experience or human rights, or combinations thereof

完全的人指:

拥有所有被认可为人权的权利

平等地拥有内在生活和观点

作为一个完整的自我而被接受

原文如下:

entitled to all rights recognized as human rights

equally in possession of internal life and point of view

welcomed as one’s full self

3 研究、发展和AI销售中的非人化

3.1 计算隐喻(The computational metaphor)

Baria & Cross (2021) 的研究认为:

隐喻是双向的

神经科学家认为:大脑是计算机(THE BRAIN IS A COMPUTER)

技术界认为:记算机是大脑(THE COMPUTER IS A BRAIN)

这种隐喻抬高了计算机的地位而低估了人类心智

暗含了理性高于感性

AI是伪造的人类智能,但因为理性而被更多的信任

Arcas (2021) 的研究认为计算机是个盲聋人,并引用盲人和盲聋人的著作说明概念并不依赖某一特定感官系统产生。但这并不能证明计算机拥有人类的内在生命、关系和完整人格。反而是非人化了盲人和盲聋人。

3.2 数字面相学(Digital physiognomy)

通过照片、视频、声音样本等信息,预测一个人的犯罪倾向、性取向、就业能力、政治倾向和精神病态特征

基于性别、种族等信息进行分类是有问题的

将人类多样的身份与经验简化为人为捏造的类别

这些类别被错误地视为本质的、不可改变的、并且可以从外部直接观察到的

这种分类是无法实现的,因为数据中没有相关信息

这种分类是有害的,因为这需要:

物化人类

僵化分类

错误地归因个体的特征与身份

3.3 立场谎言(Ground lies)

AI的训练数据集被神话,认为未尽处理的数据集是“自然产生”的,代表真实情况

数据收集的地点、方式、筛选标准、所加标签、标注标签的人、标签如何验证等环节均可能存在偏见

如果不进行处理,会得到非人化的数据

3.4 非关系性(Irrelationality)

人类对自我、生活和世界的体验始终是具有关系性的

AI的认知是非关系性的(irrelational)

人类在实际情况中依赖经验创造性地运用规则

计算机只能处理硬编码的规则或基于历史数据的统计处理,永远无法真正结合当前完整的情境来运作

非关系性贬低了人性,也抹去了人性存在的空间

让计算机做看似更理性的决定是一种逃避行为

3.5 幽灵工作(Ghost work)

数据标注、系统设计、评估和计算机处理失败时作为后备支持均需要人工

这种工作往往被外包

科技公司经常用AI来掩盖工人的劳动

众包平台鼓励任务发布者将工人视为可互换的软件组件

3.6 白人种族框架的强化(Reinforcement of the white racial frame)

英语世界关于AI的话语强化了白人种族框架,即对种族类别的隐含理解,支撑着系统性种族主义和白人至上主义

AI在英美文化中被种族化为白人,如机器人的白色外壳、语音助手和聊天机器人使用带有白人特征的语言风格

AI被赋予的特质(如智能、专业、权力)与白人特征高度重合

AI的白人化设计可能反映出:白人设计者在构建一个可供他们避开与非白人互动的服务系统

白人AI在更隐蔽的层面上具有非人化作用

WEHELIYE (2014) 认为:“黑人性”在该框架下被归为“非人”或“次等人类”状态

4 认知科学家可以做什么

4.1 质疑简化任务(Problematize simplified tasks)

机器学习任务缺乏构念效度(construct validity):算法在任务中的得分未必等于具有人类完成该类任务的能力

计算机科学的通用解决方案(general solutions)观念使得他们不使用特定数据集,可能会影响对问题本质的理解

数据集开发者和算法研究者的分工,造成了对系统能力的过度解读,媒体宣传又进行了进一步放大

认知科学家有责任介入这些任务的解释,指出机器学习关于理解和通用能力的谬误

4.2 批判性分析AI能力的主张(Critically analyze claims of “AI” capabilities)

提出关键问题

这个任务是如何定义的?

输入是什么,输出又是什么?

输入是否提供了足够的信息来生成准确的输出?

训练数据集来自哪里?是如何验证的?

这项技术是否可能被用于监控、骚扰,或其他侵犯人权的用途?

不能因为系统能看起来完成任务就默认其有效性,无法验证的系统输出是无用的

AI不仅是技术,更是一种意识形态,必须向设计系统并决定其用途的人提问:

为什么你认为这是安全的?

为什么你要以这种方式定义任务?

这种设计服务于谁的利益?

4.3 去中心化白人身份/英语(Decenter whiteness/English)

去中心化被视为默认的身份或特征(如白人身份、英语)

不明确指出这些默认身份,会导致研究结果被误读为普遍适用,削弱研究并维持白人种族框架

成功标准应涵盖所有群体,系统若对有色人种不准确即为失败

质疑AI将智能与白人身份挂钩,贬低不理性但值得重视的认知能力

心理学应承担责任,帮助抵抗AI非人化

4.4 参与公共学术传播(Engage in public scholarship)

AI科技公司塑造监管环境、争夺数据控制权并推动监控等问题应用,理性监管需要知情的公众与政策制定者

通过社交媒体和传统媒体参与公共传播,建立互助网络、反复科普

与政策制定者接触和政策倡导

透明度(transparency):公开是否使用自动化、训练所用数据

问责制(accountability):由人类为系统输出承担责任

应用现有监管规定:不应假设新技术意味着原有权利保护失效

为社会科学和人文学科研究提供足够资金

为他人开展相关工作提供空间

4.5 倡导研究资金的更广泛分配

计算机科学(尤其是AI/ML)资金过于集中,导致与其他学科的权力失衡

解决技术公平性等问题,核心学科不一定是计算机科学

大语言模型生成的内容看似专业但不一定正确

计算机科学家过早宣称问题已解决,监管者和其他决策者信以为真

4.6 设想以人为本的替代研究路径

目前AI研究投入大量资源在虚构问题(made-up problems )上,如自动化道德判断(automating morality judgments),浪费资金和自然资源

需要让现实问题从计算机科学中受益,而不是让机器学习从(虚构)问题中受益

参与机器学习会议的伦理讨论,推动行业责任感提升

5 结论

AI研究与应用过程中存在多种非人化现象,包括计算隐喻、数字面相学、非关系性、幽灵工作和白人种族框架的强化

认知科学家应发挥多重作用:质疑简化任务、批判性分析AI能力的主张、去中心化白人身份/英语、参与公共学术传播、倡导研究资金的更广泛分配、设想以人为本的替代研究路径